На конференції SEO Day з цікавою доповіддю виступив Максим Федорук, Head of SEO «Фокстрот», який вже понад 7 років в інтернет-маркетингу. Головний сеошник відомого українського гіпермаркету електроніки розповів як вижити при Google Update.

Від редакції. Перевірені поради та найцікавіші кейси – зібрали для вас в одному місці! Підписуйтесь на наш телеграм-канал та отримуйте щотижня нову порцію знань та порад!

Моніторинг позицій

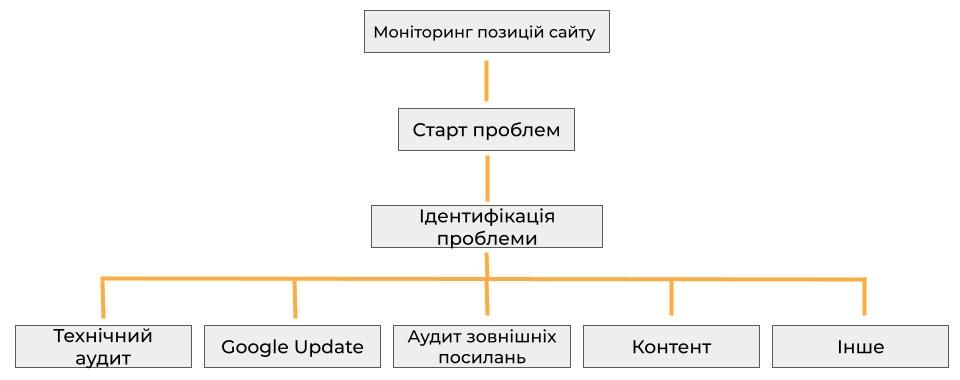

Сьогодні ми розглянемо, як вижити під час оновлень Google, але зосередимося зокрема на сайтах, які втратили свої позиції та трафік. Коли стає очевидно, що сайт вилетів з топ-10 та стає помітною знижка трафіку, важливо зрозуміти, яка саме проблема та як її знайти.

Перш за все, ми перевіряємо, в яких сервісах моніторингу позицій сайту ми зареєстровані. Це допомагає переконатись, що втрата позицій – не випадковість, а реальна проблема. Також ми звертаємося до аналітики, щоб отримати додаткову інформацію про відвідувачів сайту і їх поведінку. Це дає нам більш повний зображення стану сайту.

Якщо ми впевнені, що проблема існує, ми переходимо до її ідентифікації. По черзі аналізуємо можливі причини. Часто це пов'язано з технічними аспектами – можливими збоями в роботі сайту, що призвели до зниження рейтингу в пошукових системах. Також можуть бути проблеми з зовнішніми посиланнями, або виникла проблема зі змістом сайту.

Знаходячи вихід з кожної з проблем, ми починаємо їх вирішувати. Відновлення позицій в пошукових системах може зайняти деякий час, тому потрібно бути терплячими та послідовними у своїх діях.

Загалом, важливо розуміти, що Google старається забезпечити якісні результати пошуку для користувачів, тому він постійно оновлює свої алгоритми. Потрібно пристосовуватись до змін і розвивати свій сайт згідно з вимогами пошукової системи, тоді шанси на успіх збільшаться. Аналіз та пошук рішень допоможуть вам зберегти високі позиції і трафік на вашому сайті.

Проблеми з технічної сторони сайту

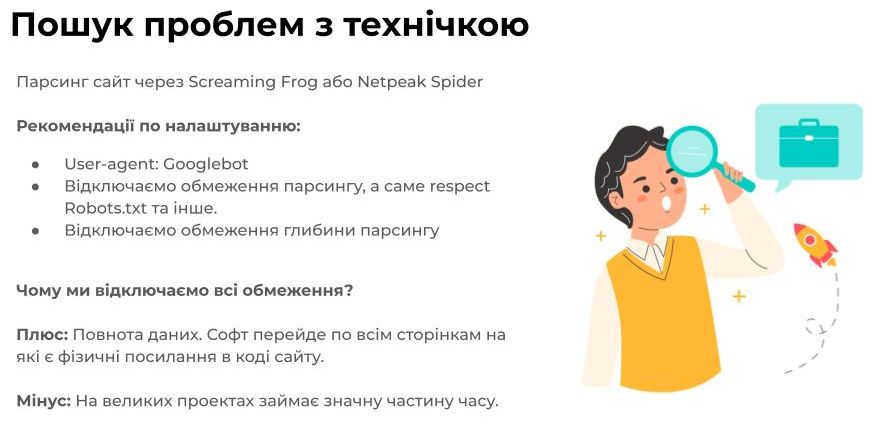

Наприклад, у нас виникли деякі технічні проблеми, але ми ще не знаємо, що саме стало причиною. В таких випадках ми застосовуємо певний підхід – запускаємо парсинг сайту. Для цього використовуємо інструменти, такі як Screaming Frog, Netpeak Spider та інші, щоб отримати базові технічні дані. Головне правило, яке ми дотримуємо, полягає в тому, щоб парсити сайт оптимально, так само, як робить це Googlebot, звертаючи особливу увагу на мобільний Googlebot.

Також, я зазвичай відключаю всі обмеження, такі як respecat robots.txt, оскільки цей файл може бути не завжди коректним, а також обмеження по глибині парсингу. Звісно, такий підхід може займати багато часу, але забезпечує велику повноту даних. У нас були випадки, коли проблема знаходилась дуже глибоко в структурі сайту, і якби ми обмежували кількість сторінок для парсингу, можливо, проблему не вдалося б виявити.

Таким чином, ми отримали дані після парсингу і ретельно проаналізували їх. Зокрема, ми виявляємо дубльований контент, проблеми з title і description, перевіряємо наявність h1 тегів, з'ясовуємо, чи є на сторінках текст та інші елементи. За допомогою такого аналізу ми можемо виявити потенційні проблеми та помилки на сайті.

Скануємо сайт на помилки

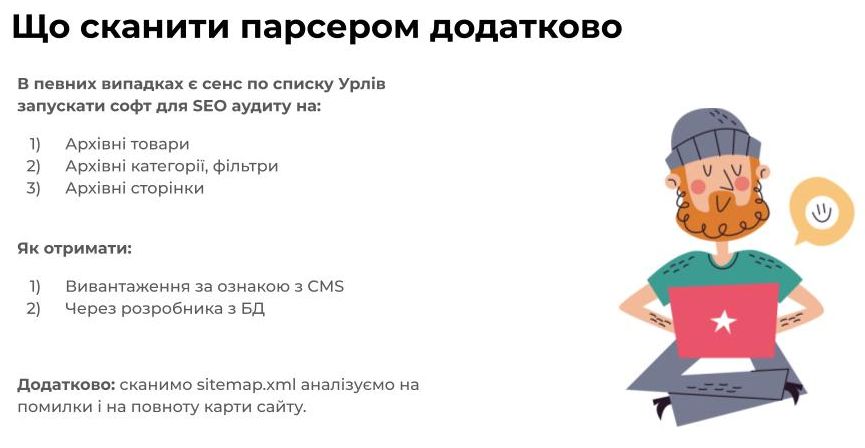

Далі, ми розглядаємо додаткові сканування для збору інформації, яку парсер не зможе знайти. Річ у тім, що парсер працює на досить простому принципі: він знаходить URL-адреси в коді та переходить за ними, збираючи інформацію. Проте, він не може знайти архівні товари, категорії фільтрів та інші архівні сторінки, які, наприклад, можуть бути недоступні для індексування або не містять посилань на самій сторінці. Тому важливо сканувати такі сторінки окремо.

Ми можемо отримати ці архівні дані шляхом завантаження сайту або через розробника, який зможе нам їх з бази даних. Додатково, ми не забуваємо просканувати Sitemap. Існує кілька причин для цього. По-перше, у Sitemap можуть бути помилки, такі як неправильно сформовані URL-адреси або помилки із редіректами. По-друге, у Sitemap може бракувати деяких важливих посилань, що може призвести до неповного індексування сайту.

Наприклад, ваш сайт може мати мільйон позитивних URL-адрес, які підлягають індексуванню, але у Sitemap можуть бути вказані лише 10 000. Це може стати проблемою, і тому ми також збираємо ці дані окремо, щоб впевнитись, що ми не пропускаємо жодну важливу сторінку.

Всі ці додаткові сканування допомагають нам отримати більш повну картину стану сайту і виявити можливі проблеми, які потребують нашої уваги.

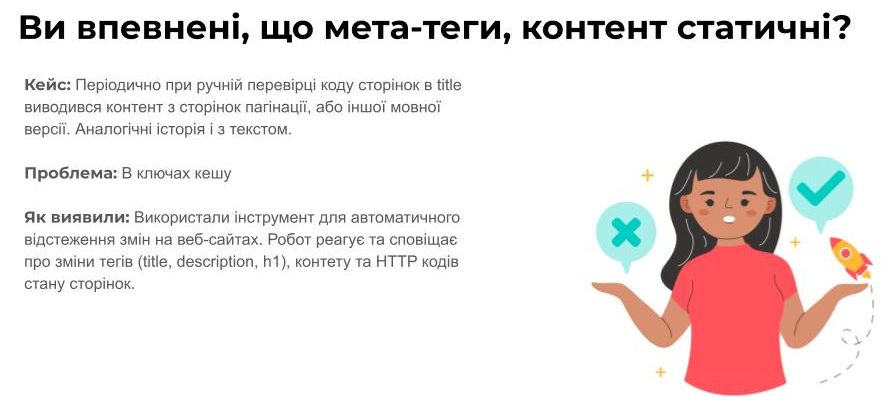

Перевірка якості контенту

Далі ми маємо звернути увагу на стабільність метатегів та контенту на сторінках. Засновуючись на нашому власному досвіді, ми періодично помічали, що при ручній перевірці коду сторінок, у метатегах title може з'являтися контент сторінок або текст іншої мовної версії. Подібні випадки виникають у зв'язку із проблемами ключа кешу, який кешує сторінки та їх елементи. Іноді наша система не може визначити, який кеш передати користувачу, і це може призводити до некоректного відображення сторінок.

Знаходити та виправляти такі проблеми може бути непросто, оскільки розробникам, які мають перевірити і відтворити проблемний кейс, може бути важко зрозуміти, що саме не працює. Для виявлення таких нюансів ми раніше використовували сервіс, який дозволяв автоматично відстежувати зміни для веб-сайтів. Ми слідкували за змінами в метатегах title, description, h1 та інших елементах.

Здійснення постійного моніторингу є дуже корисним, оскільки він допомагає виявити потенційні проблеми з метатегами, контентом та іншими важливими елементами сайту. Це дозволяє забезпечити стабільну та оптимізовану роботу сайту, що сприяє збереженню його позицій у пошукових системах.

Ручна перевірка сайту

Також є кілька інших аспектів, які ми можемо перевірити вручну. По-перше, варто звернути увагу на часті випадки проблем з рендерінгом сторінок. Наприклад, якщо ваш сайт побудований на React чи іншому скриптовому ядрі, існує можливість, що боти просто не бачать 99% вашого контенту. В такому разі, боти отримують практично пусту сторінку, оскільки більшість скриптів для них недоступні. Це може призвести до зниження трафіку, особливо після оновлень.

Щоб знайти рішення, можна розглянути можливість прирендерінгу контенту, щоб боти змогли його бачити. Приклади можуть включати різні методи, такі як Server-Side Rendering (SSR) або prerender.io. Якщо ви раніше успішно залучали трафік, але після оновлень це стало проблемою, розгляньте можливості прирендерінгу, щоб покращити індексацію вмісту.

Далі, ми дивимося на швидкість завантаження сторінок через PHP та GTmetrix на різних сторінках. Важливо звертатися до кожної сторінки окремо, оскільки велика помилка полягає в тому, що деякі люди беруть лише головну сторінку і вважають, що так сайт загружається взагалі. Для точної оцінки швидкості завантаження слід тестувати кожну окрему сторінку.

Також необхідно перевірити, чи всі елементи link присутні в коді сайту для мобільних та ПК версій. Наприклад, на мобільній версії часто використовуються бургерні меню з підвкладеннями, і у такому разі деякі пункти меню можуть бути недоступні через відсутність фізичних посилань. Також варто переконатися, що ваш фільтр на Ajax має фізичні посилання, оскільки в іншому випадку бот не зможе знайти окремі сторінки, і вас чекатимуть проблеми з індексуванням.

Ще одним аспектом для перевірки є ваш Web Application Firewall (WAF), якщо ви його використовуєте. Іноді такі файрволи можуть блокувати ботів та користувачів, що може вплинути на ваших відвідувачів та індексацію сайту.

Враховуючи всі ці аспекти та перевірки, ви зможете забезпечити стабільну та оптимізовану роботу свого сайту, що допоможе підтримувати його позиції та трафік на високому рівні.

Перевірка логів

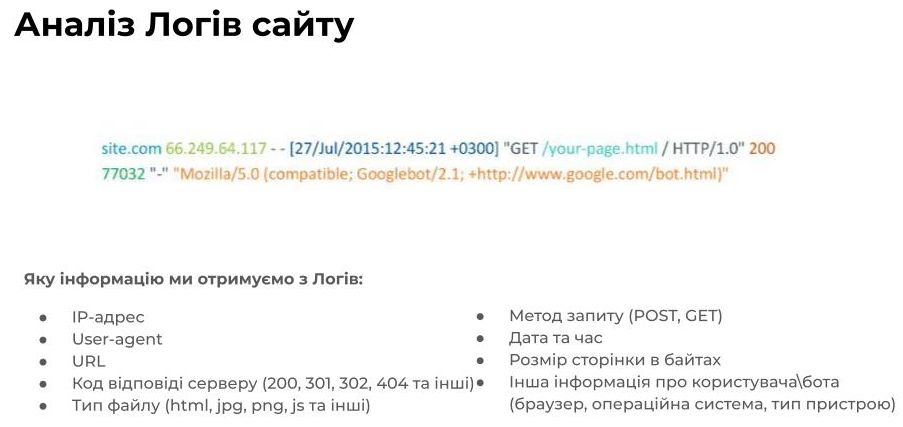

Так, коли ми вже пройшли базовий технічний аудит, ми зрозуміли головну тезу — наш парсер сканує тільки те, що ми фізично можемо знайти на сайті, але Google Bot сканує набагато більше даних. Google Bot має потужний парсер, який може отримувати дані про сторінки з різних посилань, розібрати скрипти і здійснювати більш глибокий аналіз сайту. Тому ми переходимо до аналізу логів сайту, що надасть нам додаткову інформацію.

Лог-файли містять багато корисних даних, які можуть допомогти нам отримати більш повний зображення про те, як Google Bot індексує наш сайт. З логів ми можемо вигрібати ip-адреси, юзер-агенти, які зайшли на сайт, URL-адреси, на які переходили, коди відповідей серверу, типи файлів, методи запису, дати, час, розмір в байтах та багато іншої корисної інформації.

Це дає нам велику повноту даних по всіх URL-адресах, на які переходив Google Bot. З цими даними ми можемо отримати більш детальний аналіз і зрозуміти, як Google індексує наш сайт. Аналіз логів є дуже потужним інструментом для SEO, який допомагає виявляти можливі проблеми, такі як сторінки, які не індексуються, помилки сторінок, що блокують індексацію, або неправильно налаштовані редіректи.

Збираючи і аналізуючи дані з логів, ми можемо здійснювати кращі стратегії для оптимізації сайту та збереження його позицій у пошукових системах.

Коли ми готуємося зібрати лог-файли, перш за все, потрібно вирішити, де ми будемо аналізувати ці дані. Ми можемо аналізувати логи у Kibana на власній інфраструктурі, або скористатись різними зовнішніми рішеннями, наприклад, сервісом Laxion, який є дуже потужним інструментом. Також є сервіс Jet Octopus, який дозволяє не тільки стріміти лог-файли, але також може спарсити ваш сайт через API та обробити дані з Console. Це корисний сервіс, особливо для тих, хто не дуже знайомий із Kibana або BigQuery. Хоча Jet Octopus не є дешевим рішенням, він може допомогти вирішити складні завдання з обробки логів.

Щоб ефективно працювати з великими лог-файлами, необхідно мати базове розуміння Unix-команд, оскільки часто доводиться розбивати логи на менші частини для подальшої обробки у зовнішніх сервісах. Також, якщо ви стрімуєте логи до зовнішніх сервісів, може знадобитись додаткова обробка за допомогою зовнішнього Bush, оскільки деякі сервіси можуть не правильно розпізнавати лог-файли, і вам потрібно буде вказати, які дані відповідають IP-адресам, URL-адресам та іншому.

Аналізуючи лог-файли, ми можемо здійснювати різні висновки. Наприклад, ми можемо зрозуміти динаміку відповідей серверу (200/300/400/500) і вивчити, скільки разів Google Bot заходив на наш сайт за певний період. Ми можемо побачити, на які конкретні URL Google Bot заходив та скільки разів. Також, за допомогою IP-адрес, ми можемо відслідковувати, чи не парсять нас конкуренти під user agent Google Bot і знайти ті самі URL-адреси за допомогою інших інструментів, таких як Screaming Frog або Netpeak Spider. Також, аналізуючи логи, ми можемо побачити об'єм по типу файлів та багато іншої корисної інформації.

Якщо ви плануєте працювати з лог-файлами на постійній основі, ви можете створити собі Dashboard, який буде використовуватись як Alerts для швидкої реакції на зміни на сайті. Наприклад, ви можете встановити сповіщення, якщо кількість помилок 400 зростає. Таким чином, аналіз лог-файлів допоможе вам більш ефективно відстежувати стан вашого сайту та зрозуміти, які зміни можуть вплинути на його роботу.

Працюємо з Google Search Console

Далі, ми маємо доступ до Search Console, який надає нам багато корисних звітів. Коли відбуваються зміни на сайті, ми повинні звернутись до всіх базових звітів, щоб переконатись, що немає помилок або проблем. Зазначу, що звіти в Google Search Console мають невеликий проміжок часу між збором даних, тому це не real-time інструмент, але вони дозволяють нам виявляти проблеми на дистанції.

Додатково, ви можете перевірити різні URL-адреси вручну і подивитися HTML-знімок, який отримує Google Bot, щоб переконатися, що все відображається належним чином. Також слід перевірити вкладку зі скриптами та елементами, щоб переконатися, що нічого не заблоковано. Наприклад, ви можете заблокувати деякі скрипти або елементи в файлі robots.txt, а самі не пам'ятатимете про це. Тому важливо перевірити, щоб нічого не заважало коректному індексуванню в Google.

Якщо у нас виникають проблеми з індексуванням, варто перевірити файл robots.txt в інструменті для перевірки цього файла, щоб переконатися, що він сформований правильно. Також варто перевірити URL-адреси, щоб впевнитися, що вони можуть індексуватися та з'являтися у пошукових результатів.

СЕОшим професійно!

На PRO-рівні ви володієте достатніми знаннями або готові вчитися далі. Цей рівень передбачає використання Google Cloud платформи з BigQuery для стрімінгу даних з різних сервісів SEO-аудиту, логів сайту, даних з Google Bot, витяжок з Search Console, аналітики та іншого. Ви можете об'єднувати ці дані в одній таблиці, що дозволяє проводити різноманітний аналіз.

PRO-рівень дає вам змогу працювати з великою кількістю даних в одному місці. Наприклад, ви можете здійснити аналіз того, які сторінки не обходить Google Bot або майже не відвідує. Таким чином, ви можете виявити проблеми з перелінковкою, коли сторінки з важливим контентом не індексуються через недостатню зв'язаність з іншими частинами сайту.

Один з переваг використання BigQuery полягає в тому, що ви можете з легкістю аналізувати великі обсяги даних, такі як, наприклад, 60 мільйонів URL-адрес, які були зібрані зі сканування вашого сайту. Це дає вам змогу робити детальний аналіз, який може перевищити можливості інших інструментів, наприклад, таких як Screaming Frog, який може відмовляти або працювати повільно з таким великим обсягом даних.

Такий аналіз допомагає виявляти складні проблеми та знаходити шляхи покращення SEO та індексування вашого сайту. PRO-рівень дозволяє вам глибше зануритися в дані і робити обґрунтовані стратегічні рішення для покращення видимості та ефективності вашого веб-сайту.

Не забуваємо про Google Updates

Тепер розглянемо фактор Google Updates. Можливо, з сайтом щось не так або причина в Google Updates. Щодо Google Updates, ось трохи базової інформації: ми повинні просто моніторити інформацію на ринку. Google має список оновлень, де вказані конкретні апдейти, їх дати і основні зміни. Також є офіційні сторінки Google, зокрема в соціальних мережах, наприклад, Search Console в Twitter.

Крім того, в нашій сфері існує велике ком'юніті, такі як Telegram-канали та зарубіжні новинні сайти, які надають більш повну та актуальну інформацію про оновлення. Інші корисні ресурси включають різноманітні конференції і YouTube-канали, де спеціалісти діляться своїми знаннями та практичними кейсами.

Слід регулярно оновлюватися з інформацією, відслідковувати оновлення на ринку і знаходити практичні рішення для різних ситуацій. Немає потреби вигадувати щось самому, оскільки існують досвідчені фахівці, які швидко аналізують оновлення та роблять рекомендації. Робимо ресерч інформації, щоб бути в курсі останніх тенденцій та змін на ринку SEO.

Чек-листи для сайтів, що втратили позиції під час Апдейту

Тепер ми переходимо до, мабуть, найтяжчого етапу — аудиту зовнішніх посилань. Чому він такий складний? Тому що в сфері SEO немає жорстких правил про те, що таке якісне посилання. Кожен розуміє, що сайт з великою кількістю трафіку та великою структурою — це, напевно, хороший ресурс. Але коли сайт стає заспамленим, починаються проблеми. Тому ми повинні дуже уважно перевірити зовнішні посилання.

Після технічного аудиту ми перевіряємо, чи маємо ми проблеми з посиланнями. Можливо, ми отримали посилання, які не є якісними і не враховували цього. Наприклад, можливо, ми купували посилання, або текстові посилання з'явилися на неякісних сайтах, що призвело до шлакових анкорів, де сайт з низьким рейтингом має жирні анкори, але не має трафіку. Такі посилання можуть значно погіршити статус сайту.

Існують також такі випадки, як атаки на сайт з пошуковим запитом, що використовують некоректні сторінки, які не індексуються через robots.txt. На жаль, такі практики відомі в сірих і чорних нішах. Конкуренти можуть спробувати вас «заспамити» поганими посиланнями, а також можуть копіювати ваш контент разом із посиланнями, що також може негативно вплинути на ваш статус.

Після того, як ми зрозуміли, які посилання є проблемними, ми повинні прийняти рішення, що з ними робити. Спочатку дивимося на анкори дуже уважно, оскільки анкорне посилання виглядає більш органічним для Google, ніж повна URL-адреса. Ми також перевіряємо наявність трафіку на донорських сайтах, оскільки трафік є ознакою якості сайту. Якщо донор має високий рейтинг, але трафіку немає, це може вказувати на проблеми.

Критерії для якісної або поганої якості посилань повинні бути унікальними для кожного сайту. Ви можете встановити власні критерії та стандарти якості, видаливши шлакові посилання та придбавши адекватні.

Аналізуючи критерії та перевіряючи сумнівні посилання, ми можемо значно покращити статус сайту. Це важливий крок, оскільки багато сайтів вже постраждали від оновлень Google через погані посилання. Варто пам'ятати також про співвідношення анкорів та про можливий переспам на сторінці. Якщо ваші анкори відрізняються від топ-10 конкурентів, вам слід бути обережними, щоб не стати об'єктом наступного апдейту.

В роботі над аудитом зовнішніх посилань немає жодної стандартної процедури, кожен випадок є унікальним і вимагає індивідуального підходу та аналізу.

Наступний пункт, про який варто говорити - це PBN (Private Blog Network, або приватна мережа блогів). Використовування PBN може бути дуже ризикованою стратегією. Ці сайти є дропнутими (заброшеними) та нестабільними, тому їх потрібно уважно перевіряти.

Спершу, потрібно переконатися, що PBN має достатньо трафіку, щоб пошукові системи вважали його якісним донором. Багато PBN не мають трафіку і не виконують пошукові запити в результатах пошуку, або втрачають свій трафік з часом. Також варто перевірити, чи анкори у вас якісні, і чи не відпадають посилання з сайту, оскільки PBN можуть дропатися, і посилання на них зникають самі собою.

При роботі з PBN, необхідно добре захистити вашу мережу від хакерів, оскільки ваші сайти можуть бути вразливі до атак і злому. Наприклад, сайт на WordPress можуть взламати і додати внутрішні посилання на казино або інші непов'язані теми. Також важливо слідкувати за хостингом PBN, щоб він був якісний і безпечний.

Перевірте, чи на вашому PBN не використовуються автоматичні статті з посиланнями, і чи були проведені базові роботи для усунення ознак шаблонності. Забезпечте, щоб ваші сайти не розміщувалиться на одному IP-адресі, одному реєстраторі або на одному хостингу. Такі шаблони можуть негативно позначитися на ваших доменах.

Також ретельно оберіть посилання на головних сторінках PBN. Для деяких сайтів такі посилання можуть виглядати дуже неорганічно. Перед використанням нових доменів, краще перевірити їх статус, оскільки вони можуть перебувати під санкціями. Щоб цього уникнути, підключіть Search Console до цих доменів і спостерігайте за можливими алертами.

Далі, розглянемо питання використання підклеювання (redirects) на вашому сайті. Тут можуть бути два варіанти: ви могли здійснити переїзд на інший домен (ребрендинг), наприклад, з com.ua на ua домен, або використовували сторінкові редиректів для перенаправлення відвідувачів з однієї сторінки на іншу.

Перше, на що варто звернути увагу, це перевірити, чи правильно працюють редиректів. Моніторіть, щоб не було проблем із стабільністю та вірністю редиректування. Недобре, якщо ваш сайт має проблеми з перенаправленням і втрачає частину трафіку через некоректно налаштовані редиректів.

Також треба пильнувати за тим, щоб ваш сайт не став жертвою підклеювання (phishing). Цей сценарій більше характерний для менших сайтів. Деякі хакери можуть копіювати ваш сайт та перекладати його іншу мову за допомогою редиректів, примикаючи ваш сайт до іншого домену. Це негативно впливає на репутацію вашого сайту і може змінити сприйняття його користувачами та пошуковими системами.

У разі, якщо ви здійснили багато 301 редиректів з різних доменів на ваш сайт, вам потрібно перевірити, чи все працює коректно. Велика кількість редиректів може збільшити ризик, що ваш сайт може зазнати втрат у пошукових результатах внаслідок апдейтів алгоритму Google. При таких ситуаціях ваш сайт може надовго втратити позиції в ТОПі.

Якщо вам потрібно зробити зміни в редиректах, будьте дуже обережними, оскільки неправильно виконані дії можуть призвести до великих проблем і втрат трафіку на сайті. Зробіть всі необхідні перевірки, спостерігайте за динамікою та обережно підходьте до змін на вашому сайті, щоб зберегти його стабільність та позиції в пошукових системах.

І далі, розглянемо важливий аспект - контент. Коли ми вже проаналізували усі технічні аспекти і зовнішні фактори, наша увага переходить до контенту.

По-перше, перевірте унікальність вашого контенту. Чи не було випадків, коли хтось скопіював ваш текст, і ви залишилися з неунікальним контентом? Такі ситуації можуть позначитися на вашому рейтингу в пошукових системах. Якщо ви помічаєте проблеми зі зменшенням трафіку, спробуйте перевірити контент на унікальність та, якщо необхідно, перепишіть його, щоб повернути свої позиції.

Далі, зверніть увагу на об'єм вашого тексту. Порівняйте його з об'ємом тексту у вашого конкурента, який займає перші позиції. Можливо, ваші конкуренти розкрили тематику більш детально і створили більш обсяжний контент, що дозволило їм здобути перевагу. Підійміть обсяг та детальність вашого контенту, якщо це буде відповідати потребам користувачів.

Також зверніть увагу на якість вашого тексту. Чи він добре розкриває тему і відповідає інтенту користувачів, що шукають інформацію? Уникайте водянистого контенту, який несе мало цінної інформації для читачів.

Будьте обережними, якщо ви використовуєте AI-інструменти для генерації контенту. Деякі сітки понесли втрати через недостатню оптимізацію такого згенерованого контенту, який не відповідав вимогам пошукових систем. Ретельно перевіряйте та оптимізуйте згенерований контент, щоб уникнути проблем з ранжируванням.

Також впевніться, що в тексті присутні всі ключові запити або семантичні індекси. Запити в текстах стають все важливішими для пошукових систем, тому спробуйте враховувати їх у своєму контенті. Уникайте переспаму ключовими словами, так як це може негативно позначитися на вашому рейтингу.

Також переконайтеся, що ваш контент доступний для індексування пошуковими ботами. Відкрийте доступ для індексування тексту та переконайтеся, що він відображається коректно у коді вашого сайту.

Продовжуючи аналіз, ми переходимо до елементів сторінки. Особлива увага звертається на теги h1, h2 та інші, які не відповідають темі сторінки або можуть бути оформлені некоректно. Важливо перевірити, чи стиль і вміст цих тегів відповідають контенту сторінки.

Наразі особливо актуальна тема E-A-T (Expertise, Authoritativeness, Trustworthiness) – запит на надійність, експертизу, авторитетність та досвід. Зверніть увагу, що окрім експертності, важливий також досвід, який можна передати через реальні відгуки та досвід користувачів.

Перевірте, який контент бачить пошуковий бот на вашій сторінці. Зверніть особливу увагу на кеш-сторінки та внутрішній текстовий контент через Search Console, щоб упевнитися, що він відображається правильно та не містить шлакового контенту, наприклад, pop-up вікон.

Також порівняйте елементи вашої сторінки з тими, що присутні у ваших конкурентів. Переконайтеся, що у вас є ті самі ключові елементи, які допомагають вам конкурувати з ними, такі як кількість карток товарів, фільтри, асортимент і додаткові елементи, такі як характеристики, відгуки, FAQ, таблиці з характеристиками та цінові таблиці.

Також слід звернути увагу на помилки в написанні слів і фраз на сторінках. Наприклад, якщо частину слова написано на кирилиці, а деякі букви на латиниці, це може призвести до не розпізнавання слова пошуковими системами. Уникайте таких помилок, особливо коли вони впливають на ключові слова і фрази.

Загалом, уважно перевіряйте всі аспекти вашої сторінки, щоб забезпечити її високу якість і відповідність стандартам пошукових систем. Використовуйте плагіни та інші інструменти, які допоможуть вам легко виявити проблеми і зробити необхідні виправлення.

Резюмуємо

На завершення, хочу згадати ще один аспект — інші фактори. Інші, це ті випадки, коли наші зусилля здійснюють вплив на сайт, але не вписуються в класичний аналіз. Наприклад, кейси, коли менеджер з кейтерінгу вирішує переглянути фільтр на сайті і внести зміни для кращої навігації. Також буває, що власник самостійно робить зміни, видаляє сторінки або впливає на трафік для підвищення ефективності.

Додатково, важливо враховувати випадки, коли розробники допускають помилки, які можуть вплинути на SEO. Це може бути неправильне індексування текстових середовищ, що призводить до дублювання контенту. Також, при введенні нового функціоналу або оновленні сайту, розробники можуть ненавмисно зламати SEO модуль, який працює на сайті.

Загалом, зберіть всі ці дані й аспекти разом, і ви отримаєте повнішу картину того, що відбувається з вашим сайтом на цей час. Це допоможе зрозуміти, як ефективно працює ваш SEO стратегія і які аспекти можна вдосконалити для поліпшення позицій вашого сайту в пошукових системах.

Якщо ви хочете навчитися оптимізувати сайти і стати суперменом-сеошником, ми можемо запропонувати курс SEO-спеціаліст. В процесі навчання ви проведете аудит сайту і створите стратегію просування. Також навчитесь аналізувати конкурентів і сформуєте семантичне ядро. А, прогнозуючи результати просування, зможете оптимізувати бюджет. Привабливо? Записуйтесь!

Авторизуйтесь , щоб залишати коментарі