SEO-стратег Робин Рожон рассказал, как влияет на продвижение сайта переиндексирование. Статья будет полезна SEO-специалистам любого уровня.

Труды по правильной настройке будут вознаграждены и значительным образом повлияет на ваши финальные результаты. Чем больше сайт, тем более важным становится техническое SEO. Я покажу вам, как деиндексирование более 80% индексированных страниц ведет к прекрасным результатам.

Чтобы было понятно: это не универсальный шаблон настройки технического SEO, потому что для этого понадобилось бы несколько дней.

KPI? Доход!

Приятно улучшать скорость сканирования и подобные метрики, которые сделают вас рок-звездой на конференциях и подкастах SEO, но доход — это то, что является наиболее важным для всех сайтов e-commerce.

В 2017-2018 годах основное внимание было сконцентрировано на сканировании и контролируемой индексации, потому что SEO-специалисты не хотели зависеть от суждений Google (которые чаще всего правильны, но также могут быть и ошибочными), с целью повышения дохода от органического трафика на страницы категорий.

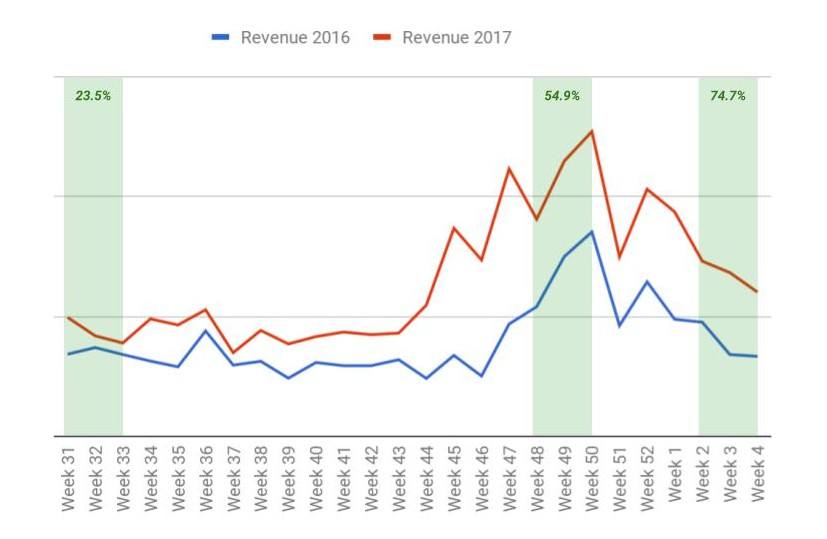

Моя команда начала производить технические изменения ранней весной и получила первые результаты в начале лета. Категорийные страницы (PLP) сгенерировали на 23.5% больше дохода с органического трафика, чем за аналогичный период прошлого года.

С течением времени доход возрастал до 54.9% роста дохода от органического трафика в категорию во время праздников. Положительный тренд продолжался и в первые недели 2018 мы зафиксировали рост более 70% по сравнению с прошедшим годом.

Да, был рост органического трафика, но это не основная наша цель, так что я вообще не буду говорить об этом.

Доход от органического трафика на страницы категорий 2016 v. к 2017

Контент — еще не все. Управляйте сканированием и индексированием

В начале года у нас было более 500,000 URL, проиндексированных Google, но мы решили переиндексировать более 400,000 URL (в основном, страницы категорий) в течение года и завершили год приблизительно с 100,000 URL в индексе Google. Моя команда удалила из индекса более 80%.

Почему так сделали? Потому что поисковые движки индексируют тонны бесполезных и повторяющихся категорийных URL.

Наша задача — помочь поисковому движку понимать структуру сайта.

Всего проиндексированных страниц в Google (скриншот сделан из Google Search Console)

Прежде, чем вы решите деиндексировать URLы, загляните Google Analytics, чтобы убедиться, что эти URLs привлекают органический трафик.

Откуда мы знали, что поступаем правильно? Просто посмотрели на процент проиндексированных URLs, которые генерировали органический трафик и число было депрессивным: только 8.55% индексированных URLs привело по крайней мере одну сессию в месяц. Это очень низкий показатель.

После нескольких месяцев тяжелой работы процент вырос до 49.7%. Еще предстоит проделать много работы, наши цели — достичь 60% и мы работаем в этом направлении.

На каждом сайте эффективная точка контакта расположена по своему. На данный сайт значительное влияние оказывает сезонность, часть ассортимента направлена на лето, оставшаяся на зиму, так что глупо было бы ожидать достижения 90%. Но, вообще-то, вы можете нацеливаться на 80-90% в некоторых сегментах бизнеса, не подверженного сезонности.

Дикие строки запроса

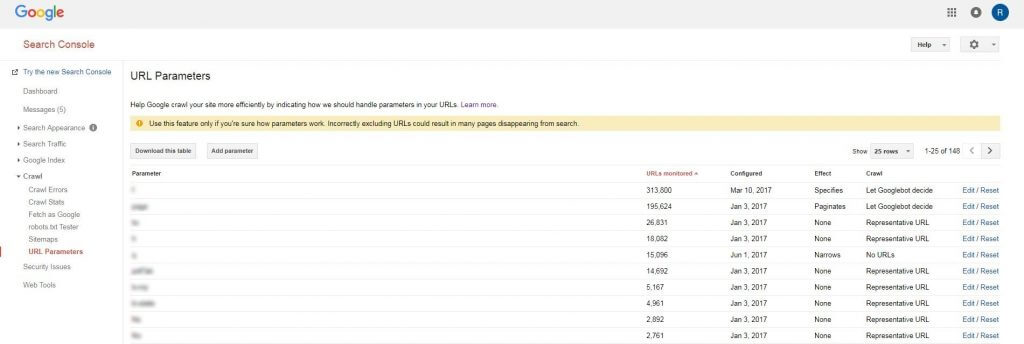

Как и каждый сайт e-commerce, на нашем сайте широко использовались параметры URL. Покопавшись в данных Google Analytics, моя команда обнаружила, что некоторые категории страниц имели 58 уникальных URL. Большинство из них были доступны к сканированию и не имели четкой стратегии.

Если дело в этом, первое, что вы захотите сделать — собрать все параметры, используемые на сайте. Соберите так много данных, как только можете (Google Search Console, Google Analytics, log files, Screaming Frog, и т.д.) и выделите все параметры. Затем проведите время с разработчиками и запишите функциональность каждого.

Мы обнаружили 150 параметров URL

Вы обнаружите, что некоторые из них не нужны, некоторые — наследие системы и т.д.

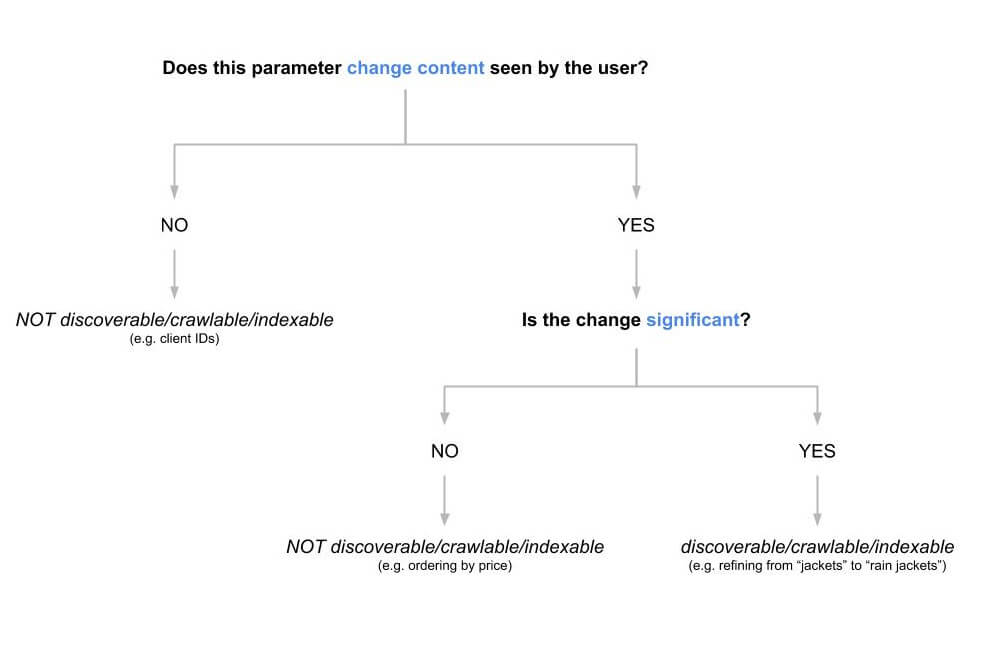

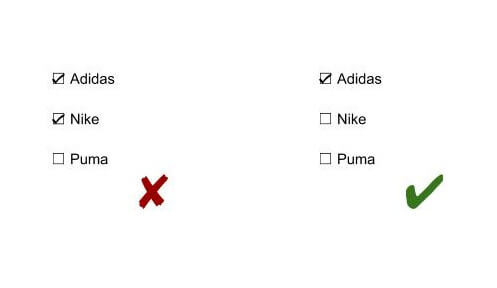

Меняет ли этот параметр контент, доступный пользователю? Если ответ:

«Нет»: высока вероятность, что вам не нужен этот параметр, потому что есть лучшие способы отслеживания. Обычно вы не хотите, чтобы эти ссылки сканировались и индексировались поисковыми системами.

«Да» и изменения значительны: эти ссылки должны быть доступными к сканированию и индексированию. Вы не хотите, чтобы поисковые системы обнаружили эти параметры, если изменения незначительны, например, изменение порядка продуктов на страницах категорий.

Изменяет ли этот параметр содержимое, просматриваемое пользователем?

Как только вы закончили составление карты и классификацию, сконфигурируйте все параметры URL в Google Search Console (Crawl >> URL Parameters) и Bing Webmaster Tools (Configure My Site >> Ignore URL Parameters).

Эти мощные инструменты позволят вам быстро произвести необходимые настройки. Но используйте их как краткосрочную меру — я все таки рекомендую позаботиться об этих вопросах напрямую в коде сайта.

Не существует единого решения, которое подойдет каждому. Может иметь смысл предотвратить распространение нового параметра, который еще не был обнаружен поисковыми системами. Если существуют тысячи проиндексированных URL с этим параметром, задумайтесь об использовании тэгов «noindex» или «canonical» вместо ограничений сканирования.

Фасетная навигация

Фасетная навигация — еще один частый источник проблем на сайтах e-commerce, с которыми мне и моей команде пришлось иметь дело.

Каждая комбинация фасетов и фильтров создает уникальный URL. Это одновременно и хорошо, и плохо, потому что создает не только тонны прекрасных лендингов, но также тонны супер-специфических лендингов, которые никому не нужны.

Вы легко можете получить тысячи URL, если примените фасеты и фильтры к странице категорий.

-

Семь брендов (Adidas, Nike, Puma …)

-

Четыре пола (Men, Women, Boys, Girls)

-

Пять рейтингов (1 star, 2 stars, 3 stars …)

-

Десять цветов (White, Black, Red …)

Этот простой пример не предлагает ничего особенного, основан на специфических характеристиках и уже создает 1400 URL.

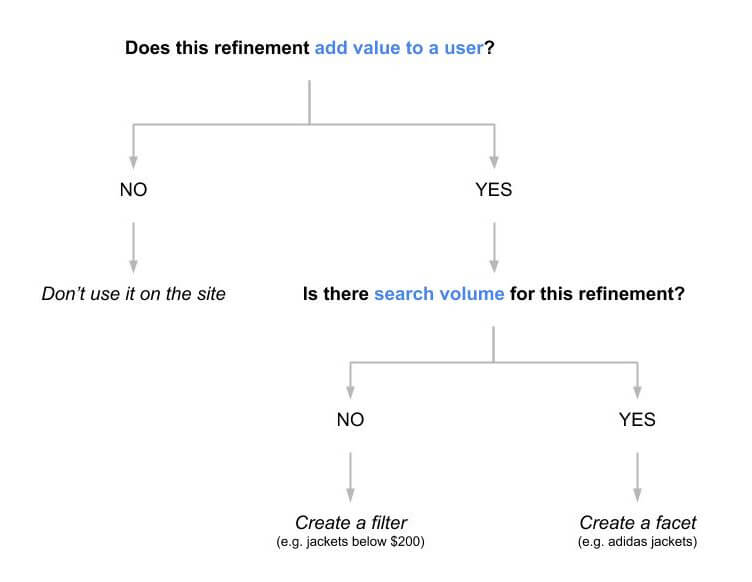

Чтобы решить, будет ли специфическое условие фасетом или фильтром, мы использовали следующее дерево.

Добавляет ли уточнение ценность для пользователя?

Зная о негативных последствиях индексации каждого из этих URL, мы убедились, что фасеты и фильтры обрабатываются по разному.

Фасеты

-

Могут быть обнаружены, просканированы и проиндексированы поисковыми системами.

-

Содержат самоссылающиеся канонические теги.

-

Не могут быть обнаружены, если выбрано несколько пунктов из одного фасета (например, футболки Adidas и Nike).

Фильтры

-

Не обнаруживаются поисковиками.

-

Содержат тег «noindex».

-

Используются параметры URL, которые сконфигурированы в инструментах Google Search Console и Bing Webmaster.

Можно поспорить, что канонический тег, ссылающийся на категорию, — лучшее решение, но для нас это не сработало, т.к. у нас были другие задачи, связанные с каноническими тегами и Google нередко их игнорировал.

Так как у нас уже были тысячи URL с индексированными фильтрами, мы не могли предотвратить сканирование этих URLs (поисковые системы не обнаружили бы теги noindex). Вы можете заблокировать сканирование через robots.txt, если поисковые движки способны обнаружить эти URL.

Все сайты разные, и не существует решения, которое подходило бы всем.

Многабукаф

Существуют миллионы веб-сайтов, которые пытаются апеллировать к более продвинутому технически SEO, но им лучше попытаться привести в норму простые вещи.

Избавление от дублирующих страниц и консолидирование сигналов на одном каноническом URL — не требует высшего образования и не звучит также сексуально, как структурированные данные, RankBrain или голосовой поиск, но все еще отличный способ улучшить свое ранжирование, трафик и, очевидно, прибыль.

От редакции: мы попросили прокомментировать статью эксперта.

Комментирует SEO-специалист агентства эффективного интернет-маркетинга WebPromo Алина Татарко:

«Страницы сайта необходимо разделять с точки зрения их потенциала для привлечения трафика. Может быть очень большое количество страниц, которые полезны для пользователя, но трафик они не приведут. Эти страницы важно закрывать комбинировано, используя тег Noindex и Search Console. При этом следует также закрывать линки на эти закрытые страницы: с помощью Nofollow, либо с использованием Ajax. Дабы не тратить ресурсы поисковой системы.

Но в некоторых случаях, когда в индексе уже много «мусорных» страниц, может быть полезно добавить их в Sitemap.xml и отправить на переиндексацию с тегом Noindex. Так бот сможет оперативно исключить их из индекса. После чего карту нужно будет почистить.

Другой вариант – использовать скрипт для удаления таких страниц через Search Console. Не стоит использовать в этом случае закрытие данных страниц через файл robots.txt – бот не будет переходить на страницы, но они так и останутся в индексе».

Если вы хотите научиться оптимизировать сайты и стать суперменом-сеошником, то можем предложить курс «SEO-оптимизация: продвижение сайтов в поисковых системах». После курсов проведете аудит сайта и создадите стратегию продвижения. Научитесь анализировать конкурентов, сформируете семантическое ядро. Прогнозируя результаты продвижения, сможете оптимизировать бюджет. Привлекательно? Записывайтесь!

Авторизуйтесь, чтобы оставлять комментарии