Однією з поширених проблем в SEO є випадання з індексу сторінок сайту. Це негативно позначається на його видимості та тягне за собою масу інших неприємних наслідків, наприклад, знижує позиції сайту і зменшує кількість потенційних клієнтів, даючи перевагу конкурентам. У цій статті ми детально розглянемо основні причини деіндексації — від низькоякісного контенту і проблем із внутрішньою структурою до технічних помилок і оновлень алгоритмів Google. Матеріал буде корисний власникам сайтів і фахівцям, які хочуть ефективно виявляти та усувати причини неполадок.

Важливість якісної індексації для SEO-просування проєкту

Проблеми з індексацією сайту й успішне SEO-просування — несумісні поняття. Тому, якщо ви прагнете розвиватися, займати провідні позиції у видачі та збільшувати прибуток, важливо постійно відстежувати індексацію, особливо якщо у вас сайт не на 3 сторінки. Неможливо мати хороші позиції у сторінки, якщо вона не проіндексована в Google, в такому випадку навіть найпродуманіший і зручний вебресурс може залишитися непоміченим потенційною авдиторією. Перелічимо основні причини, що пояснюють важливість індексації:

- видимість у Google — пошуковий бот розраховує позиції в пошуковій видачі виключно тим сторінкам, які є в індексі; якщо сторінки в індексі немає, то позицій і трафіку з пошуку у неї бути не може;

- вплив на позиції сайту — у разі об’ємних сайтів, чим більше у вас корисних сторінок в індексі, які мають посилання на інші сторінки, тим легше просувається сайт, в цілому, тому що сторінки передають внутрішню вагу посилань одна на одну;

- вплив на обсяг трафіку — чим більше корисних сторінок в індексі у сайту, тим більше точок входу користувача і, як наслідок, потенційного трафіку;

- вплив на показники якості проєкту — зазвичай проблеми з індексацією з’являються, якщо на сайті є технічні помилки, спамний контент та інші моменти, які не подобаються пошуковим системам; чим більше на вебресурсі проблем з індексацією, тим більше він має негативних маркерів для Google та інших пошукових систем, і тим гірше будуть просуватися навіть проіндексовані сторінки.

Як перевірити індексацію сайту в Google

Поліпшити індексацію сайту важливо не тільки для прискорення появи сторінок у пошуку, а й і для контролю вже проіндексованих матеріалів. Один із перших кроків для успішного просування — перевірити, як пошукова система бачить ваш ресурс і його окремі сторінки. У Google це можна зробити декількома способами:

- через пошуковий оператор «site:» — для цього в пошуковому рядку введіть «site:example.com», в результатах пошуку ви побачите кількість проіндексованих сторінок;

- через Google Search Console (GSC) — після додавання сайту перейдіть у блок «Покриття» або «Індексування», де буде видно кількість проіндексованих і виключених сторінок, також тут можна подати запит на індексацію окремих URL;

- додаткові SEO-інструменти — серед різноманіття сервісів для виявлення реальної ситуації з індексацією найпопулярнішими вважаються Ahrefs, Serpstat, Screaming Frog;

- за допомогою букмарклетів — це міні-скрипти, закріплені в закладках, які дають змогу швидко перевіряти індексованість поточної сторінки одним кліком.

Чому Google викидає сторінки з індексу

Коли падає індексація сайту, ви стикаєтеся з підступною проблемою, адже, зазвичай, це відбувається тихо і непомітно, без будь-яких попереджень з боку системи. Ще однією особливістю, яка ускладнює процес, є необхідність виявлення причин. Навіть якщо ви швидко помітили відсутність обліку сторінок у пошуку, необхідно знайти причину, а це вже вимагає професіоналізму, досвіду і глибоких знань. SEO-фахівець повинен вивчити проблему, проаналізувати фактори, що передують падінню індексації, потім вибудувати гіпотезу, перевірити її та запропонувати можливі шляхи вирішення. Нижче перераховані найпоширеніші причини того, чому сторінки викидає з індексу.

Проблеми з контентом і структурою сайту

Якщо такі базові елементи сайту, як структура і контент, недопрацьовані та неякісні, є висока ймовірність випадання сторінок з індексу. Пошукові системи все суворіше оцінюють внутрішнє наповнення ресурсів, користь і актуальність контенту, логіку переходів між сторінками, загальну зручність навігації. Сторінки без цінності, дублі, слабке перелінкування — все це заважає пошуковому роботу зрозуміти, які розділи важливі, багато чого він вважає малозначущим і викидає з індексу. Щоб поліпшити індексацію, зберегти видимість і позиції, важливо регулярно проводити аудит контенту і структури.

Контент і сторінки низької якості

Дуже частою причиною випадання з індексу є низькоякісний контент. Пошукові системи цінують унікальність, корисність, експертність, інформативність контенту для користувача. Відхиляючись від цих принципів, ви ризикуєте втратити таку важливу індексацію сторінок. Наприклад, на сайті розміщені статті, написані не людиною, а згенеровані AI без вичитки та просто під ключовий запит, або нарізані з різних джерел конкурентів і об’єднані в одну статтю, і максимально провальний варіант — звичайний копіпаст чужих робіт.

Бувають такі ситуації, коли на сайт додається подібний низькопробний контент, але індексація не припиняється миттєво. Можуть пройти місяці до чергового оновлення алгоритмів, поки пошукові боти виявлять ці тексти, набереться критична маса зауважень у Google до сайту і пошукові системи почнуть виключати сторінки з індексу. Тому для глибокого аналізу проблеми варто враховувати доволі тривалий попередній період.

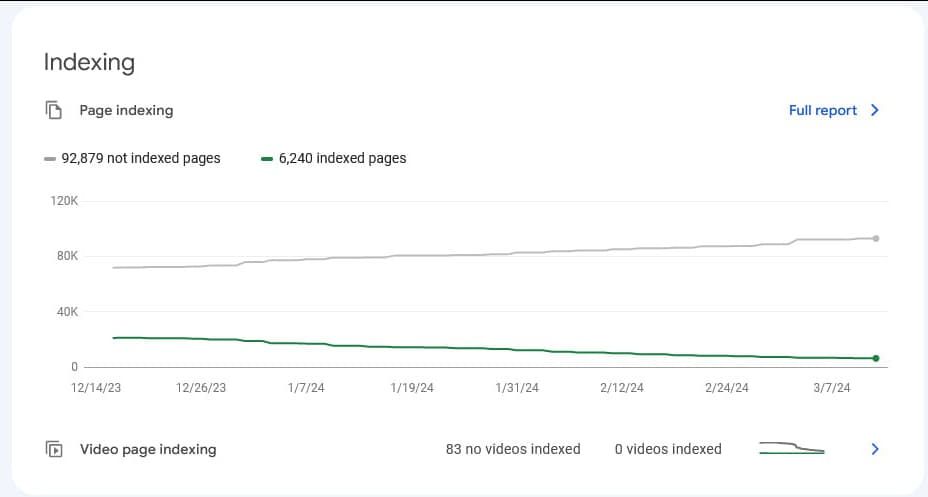

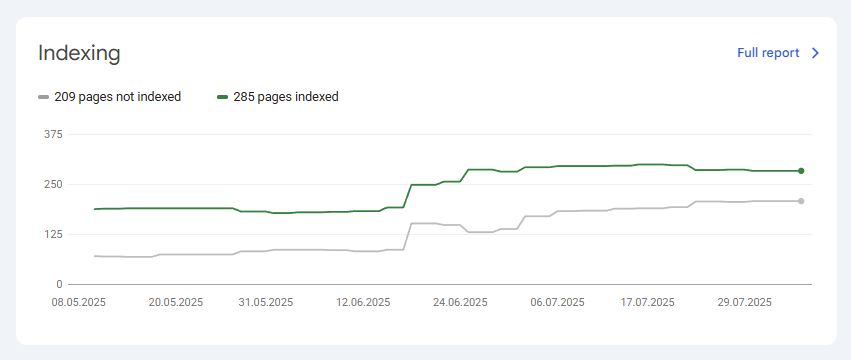

Сайт, у якого відбувається поступове випадання сторінок з індексу через їхню низьку якість, як видно, це триває не один день

Також поширеною причиною деіндексації стають неякісні сторінки в цілому. Це можуть бути, наприклад, порожні та напівпорожні сторінки, без товарів і контенту. Якщо фахівці ставляться безвідповідально до заповнення сайту, генерують за допомогою нейромережі буквально все навіть без вичитки, створюють масу дублів або просто роблять свою роботу неякісно, то рано чи пізно боти помітять це і вважатимуть марним, а отже, виключать з індексу.

Повернення трафіку сайту після заміни повністю ШІ-згенерованого низькоякісного контенту на нормальний і корисний

Для поліпшення ситуації потрібно зайнятися серйозною оптимізацією контенту. Будь-який контент на сайті має бути грамотним і якісним, нести цінну інформацію для користувача і не містити помилок. Тому доопрацюйте наявні сторінки, давши завдання досвідченому копірайтеру, переробіть, видаліть або приховайте неактуальний і застарілий контент. Важливий момент: простежте, щоб контент, в першу чергу, був корисний для користувачів і давав відповіді на їхні питання, а не писався просто для SEO.

Недостатнє внутрішнє перелінкування

Внутрішня перелінковка, крім позитивного впливу на користувальницький досвід, відіграє важливу роль для індексації: вона допомагає пошуковим системам визначити пріоритетні сторінки та взагалі важливість тих чи інших сторінок для сайту в цілому. Посилання, які не працюють, або сторінки, на які не ведуть внутрішні посилання, ускладнюють пошук і розуміння вашого сайту пошуковими системами. Якщо сторінка не має вхідних посилань з інших проіндексованих сторінок або їх мало, Google може розцінити її як малозначущу або Orphan page і з часом виключити з індексу. Подібні проблеми можуть виникати в таких випадках:

- при додаванні нових сторінок без їх інтеграції в основне меню;

- при масовому додаванні нових сторінок на сайт, наприклад, товарів або статей, коли пагінація категорій, яка повинна розподіляти вагу по цих сторінках, закрита від індексації;

- в ситуації, коли сторінки доступні тільки за прямим посиланням, але не пов’язані з іншими матеріалами.

Приклад сайту послуг із блогом із переважно унікальним контентом, але проблемною індексацією через некоректно реалізовану перелінковку і структуру в проєкті (сторінки вручну пробували відправляти в індекс, але через пару днів вони вилітали)

Найпростішим рішенням буде додавання на сайт блоків перелінковки, наприклад, «Схожі товари», «Рекомендовані статті», «З цим також купують» — це створить природні посилання між сторінками, поліпшить навігацію і перерозподілить внутрішню вагу посилань на глибші сторінки сайту, які зазвичай її не отримують. Також ви можете вручну проставити посилання з релевантних статей, категорій або блогових матеріалів. І, звичайно, не варто забувати про необхідність перевірки сайту (меню, фільтри, хлібні крихти тощо) і Sitemap.

Технічні причини

Технічні помилки часто стають прихованим джерелом проблем з індексацією: навіть якщо контент і структура сайту відповідають вимогам SEO, некоректні налаштування можуть повністю або частково закрити ресурс від пошукових систем. Особливо це актуально під час редизайну, перенесення сайту на новий домен або оновлення движка. Важливо перевіряти такі параметри до публікації, щоб не втратити сторінки з індексу і не обнулити результати просування.

Заборони на індексацію — випадкові або через злом сайту

Таке часто відбувається під час оновлення сайту. Наприклад, коли завантажують фінальну версію з тестового сервера, розробники можуть забути прибрати налаштування, що забороняють індексацію. Щоб не випасти з індексу, такі налаштування обов’язково потрібно перевіряти перед публікацією оновлень. Перелічимо докладніше, які помилкові налаштування можуть зустрічатися:

- директива Disallow у файлі robots.txt — закриває певні розділи або весь сайт від сканування;

- метатег meta name="robots" content="noindex" — вказує пошуковику не додавати сторінку в індекс;

- HTTP-заголовок X-Robots-Tag: noindex — аналог метатегу, але задається на рівні сервера;

- парольний захист або обмеження за IP — іноді тестову версію закривають паролем, а при перенесенні на робочий домен забувають зняти обмеження, через що пошуковики бачать лише головну сторінку.

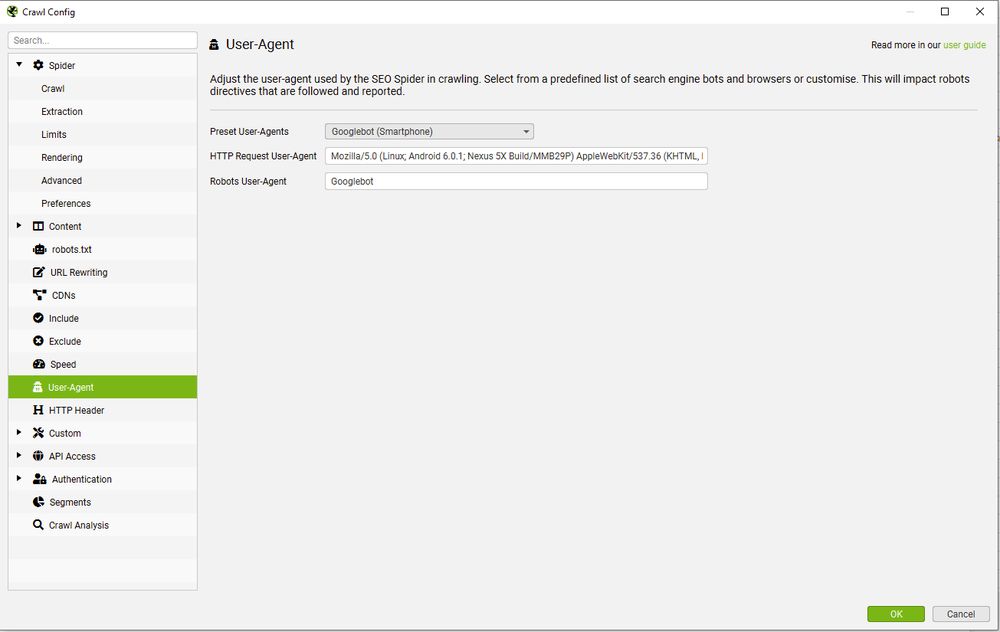

Ще одну проблему продемонструємо на цікавому прикладі. Нашою метою було з’ясувати, чому Google викидає з індексу корисні сторінки послуг. Проблема полягала в тому, що сканер Google показував заборону сторінки для індексації, але фактично, коли ми відкривали її з браузера, проблем з індексацією не було. Для з’ясування джерела походження цієї команди було побудовано кілька припущень. Можливо, noindex стоїть тільки для Google бота або, наприклад, для певних IP, з яких заходить бот. Щоб перевірити гіпотезу, ми використовували програму Screaming Frog. У налаштуваннях юзер-агента замість стандартного сканера виставили GoogleBot Smartphone або GoogleBot Desktop. Виявилося, що для юзер-агентів Google ці сторінки дійсно містили теги noindex.

Такий вигляд мають налаштування правил User-Agent для сканера Screaming Frog

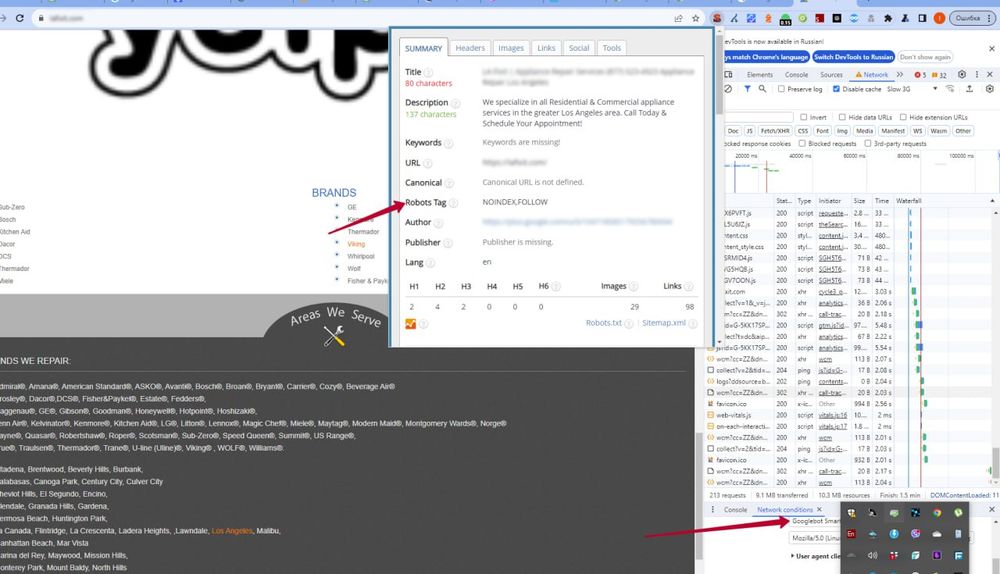

Клієнт, у якого в результаті злому був проставлений тег noindex для Google бота

Почавши пошук причин, з’ясувалося, що в минулому був злом на клієнтському проєкті через SEO-плагін. Зломники зробили закриття від індексації сторінки тільки для юзер-агента Google, а для всіх інших — спеціально не закривали, щоб ускладнити та затягнути процес виявлення злому. Після видалення шкідливого коду ситуація нормалізувалася: сторінки повернулися в індекс і пошукова система знову почала коректно працювати із сайтом. Даний кейс показує, що заборони на індексацію можуть бути як явними (robots.txt, meta noindex), так і прихованими (вибірковий noindex для ботів, певних IP тощо). Тому важливо регулярно перевіряти сайт, виходячи з різних ідей, включаючи поведінку пошукових агентів.

Дублі сторінок

До зниження рейтингу і втрати трафіку може призводити наявність однакового або схожого контенту на декількох сторінках. У такому випадку пошукові роботи не можуть визначити, які сторінки більш авторитетні та релевантні для конкретного пошукового запиту. До того ж через створення дублів пошукова система може запідозрити вас у маніпуляціях результатами SERP і повністю видалити з пошукового індексу. Що можна зробити, якщо схожі сторінки вам все ж потрібні та варіант видалення не розглядається:

- використовувати тег «rel=canonical» в head;

- налаштувати редирект 301 зі сторінки-дубля на канонічну сторінку;

- зробити всі схожі сторінки унікальними, змінити метатеги, описи, фото та інше.

Непродумана зміна URL (ЛЗУ — людино зрозумілі урли)

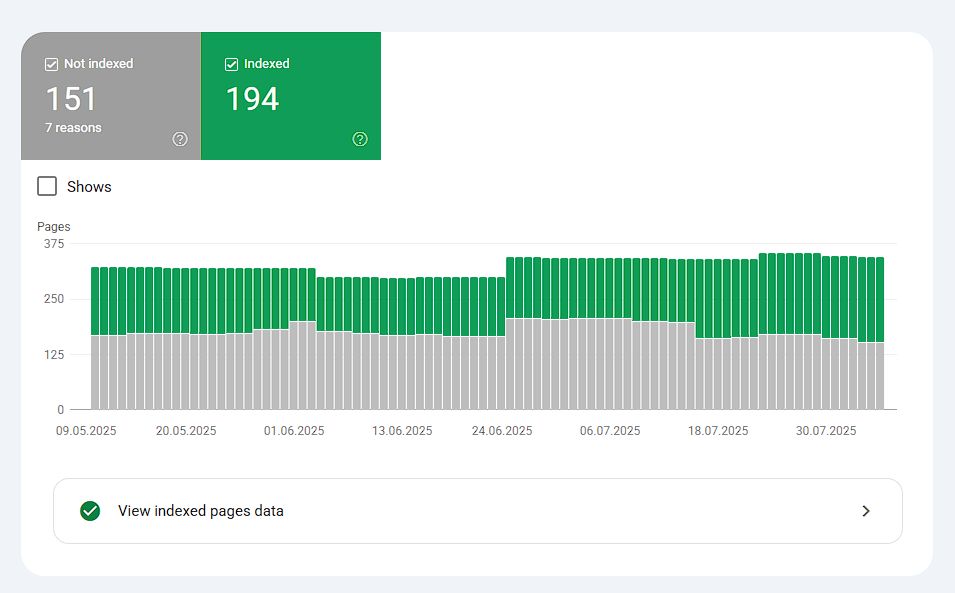

Зміна структури URL незмінно супроводжується випаданням з індексу. Це закономірний процес, який навряд вдасться обійти, але його можна прискорити. Для процесу зміни урлів потрібно, щоб стара сторінка випала з індексу, а нова зайшла. І не завжди ці моменти відбуваються паралельно. В одному проєкті під час зміни ЛЗУ кількість неіндексованих сторінок зросла з 87 до 153, а кількість проіндексованих — зі 193 до 250. Це означає, що одні сторінки випали, інші замінили їх.

Приклад такого випадку — у клієнта була повністю перебудована логіка формування урлів і налаштовані редиректи, але при цьому при подачі на індексацію оновлених урлів зростала кількість неіндексованих і проіндексованих сторінок

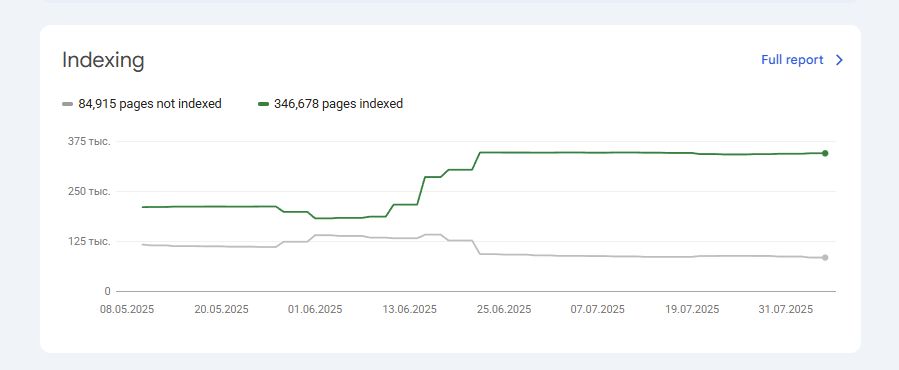

Схожа ситуація в іншого клієнта — тут була змінена структура формування URL-адрес, але при цьому редиректи ніхто відразу не налаштував, тому облік нових сторінок йшов набагато довше в міру налаштування редиректів

Основні причини таких проблем:

- відсутність або некоректне налаштування редиректів 301;

- поява помилки 404 на старих або нових сторінках;

- цикли перенаправлення (Redirect Loop), спровоковані друкарськими помилками або помилками в .htaccess;

- зміни CMS, налаштувань сервера або структури папок, які зачіпають URL-адреси.

На жаль, у випадку зі зміною URL уникнути їхньої переіндексації та випадання старих варіантів з індексу неможливо. Це тягне за собою і тимчасове просідання сайту на кілька тижнів або місяців. Тому, якщо є необхідність впровадження нових адрес сторінок, бажано робити це якомога раніше, поки сайт ще новий, не надто великий і не встиг вийти на високі позиції — тоді просідання буде менш помітним. І найважливіше — необхідно налаштувати редиректи 301 зі старих адрес на нові. Тільки такий алгоритм дій дозволить зробити перехід на новий формат URL менш болючим.

Після налаштування редиректів на нові адреси рекомендується перевірити їхню роботу через Screaming Frog або аналогічний сканер. Це допоможе виявити помилки 404 і циклічні редиректи. Також важливо замінити тимчасові редиректи 302 на постійні 301, щоб пошукові системи швидше оновили свої дані з урахуванням нових урлів.

Після внесення змін до структури URL або налаштування редиректів корисно повторно індексувати сторінки сайту через інструмент «Перевірка URL» в Google Search Console. Щоб заощадити час і ресурси, можна відправляти не всі сторінки поспіль, а найбільш ключові, і з них бот далі буде переходити на інші сторінки самостійно. Завдяки цій функції ви можете точно знати, чи потрапила потрібна сторінка в індекс. Тільки майте на увазі, що процес переіндексації може зайняти кілька днів або тижнів, тому результати варто оцінювати не відразу, а через деякий час.

Інші можливі причини

Крім технічних і контентних факторів, на індексацію сайту можуть впливати й інші причини, які необхідно враховувати під час комплексного SEO-аналізу. У цій статті ми розглядаємо найпоширеніші причини, адже їхня загальна кількість дійсно величезна. На жаль, деякі фахівці не заглиблюються в суть і особливості бізнесу, а просто застосовують стандартні підходи. В результаті пошук проблем і перевірка гіпотез затягується на довгі місяці, що негативно позначається на видимості сайту у видачі. Важливо розуміти, що пошукові системи постійно змінюють правила гри, а невдалі рішення, такі як надмірна кількість вихідних посилань, можуть негативно вплинути на сприйняття сайту. У наступних розділах розглянемо це докладніше.

Оновлення алгоритмів Google

Одна з найчастіших причин випадання з індексу — оновлення алгоритмів Google і правил оцінки якості контенту, адже система постійно вдосконалюється. Якщо черговим таким оновленням став підхід до оцінки якості контенту, то є ризик, що деякі сторінки почнуть деіндексуватися. Один із наших кейсів — яскравий тому приклад. У якийсь момент на сайті клієнта перестала індексуватися спочатку одна група сторінок, потім наступна, хоча до цього все було стабільно. У нашому випадку Google (після чергового апдейту) вважав багато сторінок низькоякісними через те, що на них було мало внутрішніх посилань або їх не було зовсім. Після впровадження блоку «Схожі товари» індексація була відновлена, ба більше, навіть покращена.

На сайті товарні картки недоотримали внутрішню вагу, оскільки пагінація на категоріях була закрита від індексації та Google став їх викидати з індексу. Впровадження блоку «Схожі товари» на сторінках переломило цю ситуацію

Безліч вихідних посилань

Така проблема часто зустрічається на сайтах, які продають посилання. У них більше вихідних посилань, ніж навпаки. Для пошукової системи це ознака низькоякісного ресурсу, або створеного спеціально під посилання, а значить, такого, що не несе ніякої користі. Контент таких статей часто дуже слабкий. Зазвичай, випадання з індексу зростає в міру збільшення кількості розміщених таким чином статей. Тому рекомендуємо не зловживати розміщенням низькоякісних статей із вихідними посиланнями на інші ресурси та наповнювати сайт якісним власним контентом для балансу. Інакше буде спостерігатися плавне падіння трафіку і випадання сторінок з індексу.

Як уникнути проблем з індексацією

Якісна індексація — основа успішного SEO і стабільного просування. Для збереження позицій важливо не просто вирішувати проблеми в міру їхнього виникнення, а й запобігати їм. Для цього потрібно регулярно контролювати стан сайту, структуру і технічні налаштування, звертати увагу на якість контенту і його актуальність. Помилки в URL, погана перелінковка, низька унікальність і якість контенту, дублі та заборони на індексацію здатні серйозно нашкодити видимості, поставивши на стоп ваш органічний ріст. Постійно аналізуйте вебресурс, застосовуйте актуальні інструменти та своєчасно виправляйте помилки — це допоможе уникнути втрати сторінок і зберегти довіру пошукових систем.

Авторизуйтесь , щоб залишати коментарі